W poradniku zaprezentuję kolejne darmowe narzędzie pomocne w sytuacjach, kiedy musimy pozyskać dane z Google bądź innych witryn. Simple Google Scraper posiada kilka modułów, podstawowy do wyodrębniania danych z wyszukiwarki oraz Regular Expression Extractor do wyciągania ze stron internetowych określonych informacji, na przykład adresów proxy, katalogów cze też adresów e-mail. Program bardzo pomocny i dostępny całkowicie za free.

Prezentacja Simple Google Scraper

Najważniejsze cechy aplikacji:

- Szybka,

- Obsługuje proxy,

- Pozwala ustawić opóźnienie między kolejnymi zapytaniami,

- Wspiera zaawansowane operatory wyszukiwania jak site, intitle czy inurl,

- Umożliwia pobranie tylko najświeższych danych (z ostatnich 24h),

- Oferuje opcję do zmiany lokalizacji wyszukiwania np. przesiadka z .com na .pl,

- Posiada inteligentny silnik wyszukiwania, który minimalizuje ryzyko zbanowania adresu IP,

- Inteligentnie zarządza wątkami (liczba jednocześnie wykonywanych wątków zależy od ilości słów kluczowych oraz czasu opóźnienia),

- Zawiera moduł do ekstrakcji danych ze stron internetowych (przy użyciu wyrażeń regularnych),

- Oferuje podstawowe opcje filtrowania.

Simple Google Scraper można pobrać z tej lokalizacji.

Najważniejsze elementy:

- Keywords – lista słów kluczowych (footprintów), każdy nowy zestaw od nowej linii, można użyć zaawansowanych operatorów wyszukiwania,

- Change Google Location – zmiana lokalizacji wyszukiwania,

- Google Time – ograniczenie wyników do podanego przedziału czasowego: kiedykolwiek/ostatnie 24h,

- Proxy – lista adresów proxy w standardowym formacie IP:PORT,

- Load From File – wczytanie zestawu słów/proxy z pliku tekstowego,

- Delay – czas opóźnienia wyrażony w sekundach,

- Results – lista wyników,

- Export To Text File – zapis wyodrębnionych danych do pliku tekstowego,

- Export URL & PR To CSV – zapis danych wraz z PR do pliku w formacie CSV,

- Tools – opcje do filtrowania, pobierania PR, a także dodatkowe moduły jak RegEx Extractor.

- Przycisk D – usuwanie duplikatów i sortowanie,

- Przycisk L – wczytuje listę URL z pliku tekstowego.

- Start/Abort Scraping – Uruchom/Zatrzymaj wykonywanie zadania.

Pracę z programem rozpoczynamy od wprowadzenia footprintów. Jeśli mamy sporą listę warto dodać przynajmniej kilka adresów proxy oraz ustawić czas opóźnienia. Jak sprawdzić czy dane proxy będzie działało z Google? Można do tego wykorzystać program Google Proxy Checker (również darmowy). Następnie pozostaje tylko wskazać Start Scraping i wyjść na kawę.

Program cierpi na jedną dość poważną przypadłość, mianowicie nie ma przycisku resetowania listy wyników, jedyne wyjście to użycie funkcji Remove URLs Containing (w menu Tools). Można też zauważyć rozbieżności w wynikach (zapytanie dokonane w przeglądarce zwraca nieco inne wyniki). Dotychczas nie zagłębiałem się w temat, więc nie mogę powiedzieć z czego wynika różnica.

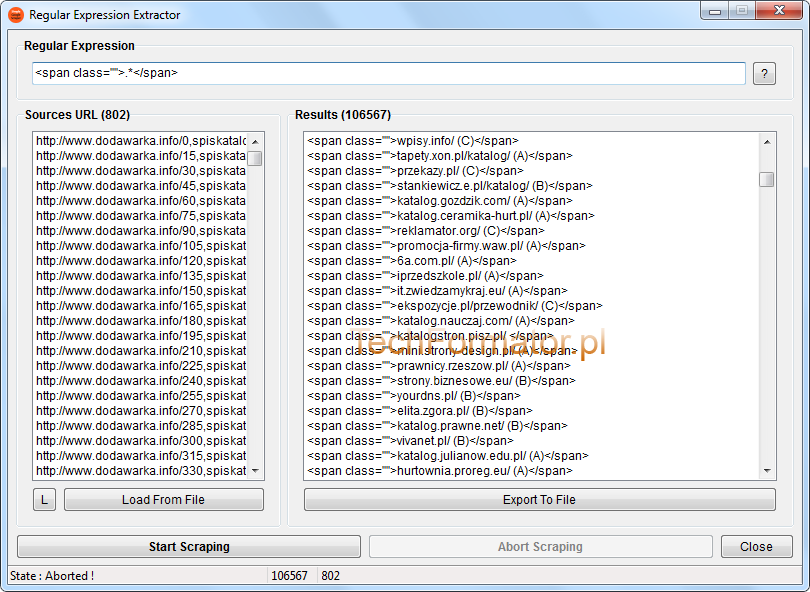

Kilka słów o… Regular Expression Extractor

Teraz pora omówić moduł Regular Expression Extractor, który znajdziecie w menu Tools.

Wczytujemy listę stron (Load From File), w polu Regular Expression wprowadzamy wyrażenie w formacie zgodnym z PCRE/PERL i uruchamiamy proces Start Scraping.

W ten sposób można szybko stworzyć listę katalogów, wydobyć proxy ze stron lub pozyskać adresy e-mail. Niestety moduł posiada ten sam problem co formularz główny, brak przycisku resetowania listy wyników, co gorsze nie znajdziemy też funkcji Remove URLs, przez co każdy nowy projekt wymaga restartu okna RegEx. Do tego wkurzający komunikat dotyczący zamknięcia okna ekstraktora, lecz da się to przeżyć.

Osobiście nie przepadam za RegEx, wolę do pozyskiwania danych używać XPath scraperów, są szybsze, dokładniejsze i łatwiej tworzy się w nich formuły. W jednym z kolejnych artykułów przedstawię jeden taki darmowy programik więc warto śledzić bloga na Facebooku lub poprzez kanał RSS.

Podsumowując, Simple Google Scraper uważam za bardzo interesujący projekt. Warto przetestować!

Świetna sprawa! Nie miałem pojęcia, że istnieją darmowe programy tego typu.

Ciekawe jak wypada w konforntacji z SB, hreferem i LicorneAIO – potestujemy 🙂

Dzięki za informację!

Bardzo fajna prezentacja narzędzia. Na pewno je przetestuję, może wezmę się za własną recenzję. Wyciągnięcie katalogów na pewno mi się przyda.

Nie pozostaje nic innego jak pobrać program i przetestować , z opisu i screenów wygląda ciekawie 😉

Naprawdę fajny kawałek softu. Szkoda, że zasysa tylko z Google. Jakby co, to jest jeszcze darmowy SickScraper, nie pamiętam czy była o nim mowa w tym miejscu.

Niestety SickScraper nie był opisywany, dzięki za wspomnienie o nim.

Ten soft jest dość popularny więc nie było sensu pisać po raz n-ty o nim 😉

Trzeba odkopać inne mało znane perełki.

Bomba!! Jeden z najlepszych darmowych skraperów jakie testowałem! Ciekaw jestem ile takiego dobrego softu ukrywasz przed nami 😛 🙂

Niezła zabawka, ładnie mi scrapuje wyniki i… wysypuje się 😛 Ale z drugiej strony i tak mam zamulonego kompa od różnorakiego softu.

W ogóle to fajne narzędzia prezentujesz, miło się czyta 🙂

Bardzo ciekawa aplikacja! Już mam kilka pomysłów jak ją wykorzystać 🙂 Nie wiedziałem, że są tego typu programy zupełnie za darmo. Naprawdę fajna sprawa.

Narzędzie wygląda fajnie – spróbuję się pobawić. A o co chodzi z tymi najświeższymi danymi? ZAindeksowane w ciągu ostatnich 24h?

Eset coś krzyczy na plik z Google Indexer Checker 1.2 beta, ze coś inby z nim jest niezbyt tak i przerywa połączenie. Wcześniejszą wersję pobiera się bez najmniejszego problemu…

Chyba pomyliłeś artykuły ale odpowiem na to pytanie. Była już o tym mowa. ESET jest nadwrażliwy na GIC i pluje fałszywymi alarmami. Dodaj plik do wyjątków i będzie ok.

Faktycznie, przeglądałem dwa artykuły jednocześnie i skomentowałem nie tu gdzie trzeba, sorry za bałagan. Ale zeby nie rozbijać już na kometowanie w dwóch miejscach, co do dodawania do wyjątków… moze warto wysłać zgłoszenie do ESETa, skoro alarm fałszywy?

Problem dotyczy każdej aplikacji używającej CodeFort nie tylko mojej, najłatwiej dodać do wyjątków i po zawodach.

Myślisz że zgłoszenie do Eseta FP coś da?

Jeśli alarm jest fałszywy, to na pewno przeanalizują to i uwzględnią, to jednak jeden z lepszych antywirów na rynku, raczej sprawdzają informacje zarówno o plikach podejrzanych, jak i fałszywych alertach. A z drugiej strony trudno instalować coś „na słowo honoru” jeśli nie zna się autora osobiście (zero zarzutu, czysty pragmatyzm). Sam zanim zainstalowałem sprawdziłem na innym kompie innym antywirem (Avast normalnie przepuścił, więc włązyłem)

Wątpię że cokolwiek zrobią, nie oni pierwsi specjalnie podwyższają czułość, żeby liczba wykrytych rzeczy była wysoka i userzy mieli poczucie, że program ich chroni lepiej niż inne podobne. Eset to akurat jeden z bardziej upierdliwych antywirów jakie używałem, dlatego na kompach domowych nie używam tego badziewia, bo ma zbyt paranoiczne podejście do bezpieczeństwa. Poza tym, chcesz uruchamiasz, nie chcesz nie uruchamiasz proste, nikt nikogo nie zmusza, a chciałbym też zauważyć, że w wątku głównym masz podane linki do Jotti i virustotal więc wszystko jest transparentne i powinieneś tam wpierw szukać odpowiedzi na swoje wątpliwości.

Panowie a w czym ten soft jest lepszy od sb czy hrefera?

Działa to lepiej czy po prostu alternatywa dla osób, które nie mają wspomnianych przeze mnie narzędzi?

jak dla mnie to program nie działa albo coś źle robię. Wpisałem taki sam footprint jak na screenie a on nawet nie pokazał mi adresów z końcówką .edu :/

Mnie wszystko pokazuje 😛

Ale to fakt, jak porównam dane ze scrapera wykorzystującego SeoQuake to jest różnica.

Program działa całkiem ok, lecz niestety Scrapeboxowi na razie nie dorównuje. Pozostanę przy tym narzędziu, ale chętnie polecę ten post znajomym, którzy szukają czegoś darmowego z funkcją wyszukiwania po regularnych wyrażeniach. Dzięki za opis i wskazanie tego programu szerszemu gronu użytkowników.

Wielkie dzięki! Programik bardzo fajny, działa szybko, nie tnie się i nie obciąża sprzętu – duży pozytyw! Wyciągnąłem jakieś stare raporty z dodań i przeleciałem je na szybko – teraz widzę ile dawniej wykonanej pracy jest jeszcze do zaindeksowania 😉

Wygląda na ciekawy program. Jaki daje rezultat w porównaniu z SB? Zastanawiam się nad kupnem scrapeboxa, ale z tego co widzę, darmowym softem można go zastąpić.

Dopiero zaczynam przygodę z tego typu programami więc dobrze się składa że na początek jakieś darmowe narzędzia są 🙂

Ręcznie udało mi się wyciągnąć jeden link w domenie rządowej i zacząłem szukać informacji jak to hurtowo zrobić i tak trafiłem na tą stronę. Zaraz zaczynam kombinowanie i szukanie potrzebnych danych do „promocji” stron jaki próbuję wyprowadzić na prostą czyli przynajmniej do top20 🙂

Pozdrawiam i powodzenia życzę w wyciąganiu danych!

program zawiesza się podczas scrapowania i wywala się komunikat o jego zamknięciu. Miał ktoś taki problem już?