Każdy audyt SEO rozpoczynamy od zebrania danych używając do tego celu różnego typu oprogramowania, od darmowego (Netpeak Spider, Visual SEO Studio, IIS SEO Toolkit, WildShark SEO Spider), aż po komercyjne desktopowe aplikacje. Na rynku funkcjonują również narzędzia on-line, które udostępniane są w modelu abonamentowym. W tym wpisie jednak nie będę pisał o drogich narzędziach on-line, a o kolejnym małym zgrabnym desktopowym i w dodatku darmowym programie, który może pomóc zebrać informacje o witrynie, do późniejszego wykorzystania w audycie SEO.

Aplikacja nosi nazwę BeamUsUp SEO Crawler, napisana jest w języku programowania Java, dlatego też sofcik uruchomimy na wszystkich popularnych platformach Windows (XP, 7, 8, 10), Linux i Mac. Wystarczy zainstalować środowisko JRE.

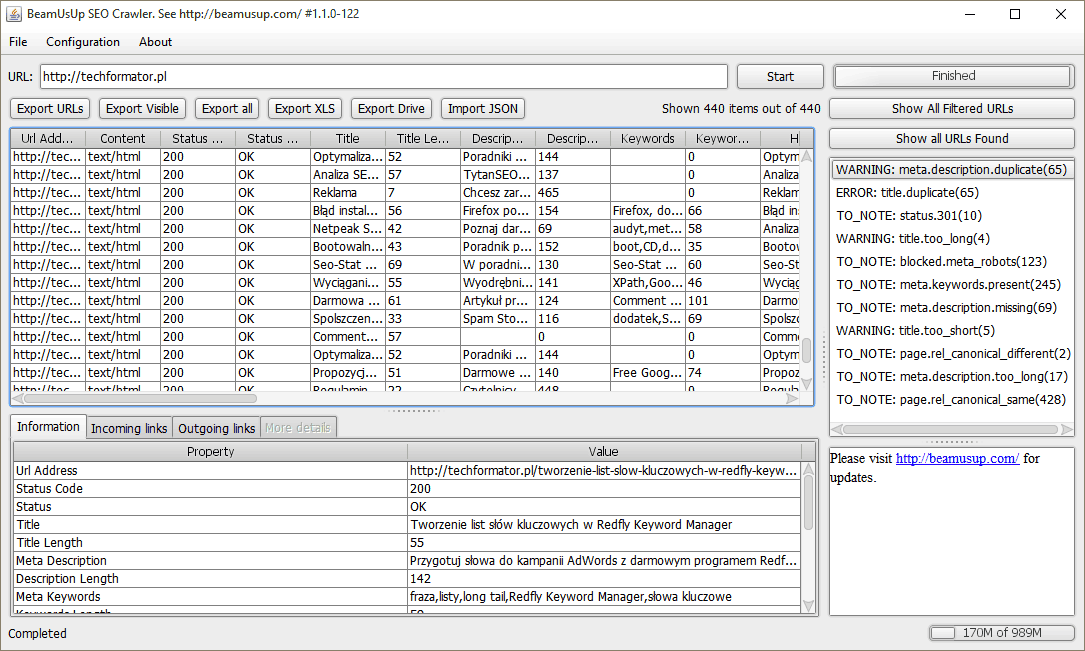

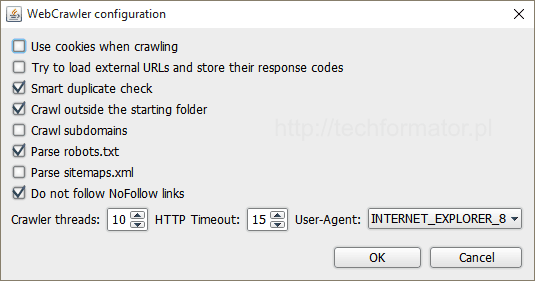

Program jest szybki, w konfiguracji programu możemy ustawić liczbę wątków, ograniczyć liczbę przetwarzanych URLi, a także włączyć inteligentne wykrywanie duplikowania (Smart duplicate check), choć owa nazwa (funkcja) na wyrost, albowiem program wprawdzie prawidłowo informuje o duplikowaniu meta opisów (w testowym przykładzie podstrony paginacji), ale już nie uwzględnia kwestii noindex, który na podstronach paginacji występuje (podstrony z noindex, jako że są wykluczone z wyników nie klasyfikuje się jako duplikaty). Dlatego jak zwykle, po zebraniu danych, musimy jeszcze wszystko dokładnie przeanalizować, uwzględniając sprawy, których autor narzędzia nie wziął pod uwagę.

W opcjach konfiguracyjnych brakuje podstawowych rzeczy, jak choćby możliwości ustawienia własnego User Agent oraz ustawienia czasu opóźnienia dla każdego wykonywanego żądania HTTP.

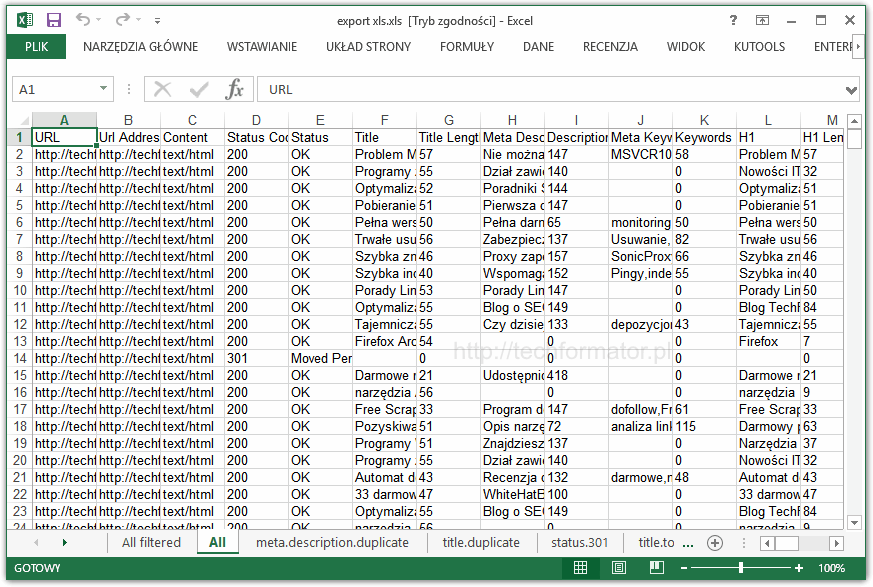

Autor BeamUsUp bardzo fajnie rozwiązał kwestię prezentacji i filtrowania wyników, wszystko jest dostępne z poziomu okna głównego, maksymalnie jednym kliknięciem możemy łatwo przechodzić między poszczególnymi filtrami i sekcjami. Za to duży plus. Brakuje opcji ukrywających kolumny, już sama funkcja pozwalająca na reorganizację kolejności kolumn byłaby niezwykle pomocna, podczas analizy danych wprost z poziomu okna BeamUsUp, a tak to trzeba dane wyeksportować do arkusza kalkulacyjnego. Oprócz XLS do dyspozycji mamy także eksport danych do CSV. Poniżej przykładowy raport w XLS…

W pliku XLS znajdziemy wszystkie przecrawlowane strony (All), jak również dane odnoszące się do konkretnych typów błędów. Raporty w sekcjach meta.description.duplicate czy title.duplicate obowiązkowo powinny zawierać kolumnę wskazującą, czy na danej podstronie zastosowano noindex, w przeciwnym wypadku analiza duplikowania, w oparciu o dane z zakładki nie ma sensu.

BeamUsUp SEO Crawler to z pewnością ciekawe i perspektywiczne narzędzie, któremu warto dać szansę.