To jest najobszerniejszy artykuł jaki pojawił się na blogu TechFormator (ponad 35 tyś. znaków) i zarazem najbardziej rozbudowana prezentacja aplikacji SEO z konkretnymi propozycjami zmian. Czy najlepsza? Sami ocenicie. Programu SEO Odkurzacz używam od dłuższego czasu. Wiem w którym miejscu mnie wkurza, a w którym zachwyca. Sam także próbowałem zrobić swój program do analizy linków, kilka modułów nawet udało się zrobić, jednakże z braku czasu musiałem zawiesić ów projekt. Cóż… dzięki temu zyska SEO Odkurzacz, który może przejąć choć część moich pomysłów.

Na wstępie muszę zauważyć, że poczyniono znaczny postęp – w porównaniu do poprzedniej wersji, program zyskał kilka ciekawych funkcjonalności, które wyraźnie skracają czas analizy. Część recenzji napisałem przed wydaniem wersji 1.1, pod wpływem nowych funkcji musiałem zmienić jej postać i również dostosować końcową ocenę do aktualnych możliwości programu.

Recenzja przedstawia moje wrażenia z prawie 2-miesięcznego użytkowania. Oprogramowanie kupiłem za własne pieniądze – jeszcze wtedy nawet nie sądziłem, że napiszę recenzję o SEO Odkurzaczu. Autor softu nie nalegał na recenzję, inicjatywa wyszła ode mnie.

Dodam że testowanie oprogramowania (w konsekwencji jego ulepszenie) i napisanie kompletnej recenzji, na zachodzie kosztuje ciężkie pieniądze. W Polsce do takich rzeczy wynajmuje się studentów, którzy o testowaniu aplikacji SEO mają pojęcie niewiele większe, niż ja o naprawie samochodów.

W niektórych miejscach twardo napisałem co mnie boli, co uwiera, w innych przypadkach pochwaliłem niektóre rozwiązania. Mam nadzieję, że dzięki tej recenzji autor udoskonali aplikację i każdy czytelnik zainteresowany SEO, a w szczególności kwestiami analizy profilu linków i/lub konkurencji skorzysta na tym.

Do jakich zadań możesz wykorzystać program SEO Odkurzacz?

- Audyt linkowania w aspekcie analizy konkurencji,

- Analiza profilu linków pod kątem przygotowania zestawu danych (linków) do narzędzia Google Disavow Tool,

- W przypadku depozycjonowania lub kampanii *czarnego PR – do zebrania materiałów dowodowych.

*Czarny PR w odniesieniu do SEO oznacza pozycjonowanie strony konkurencji na negatywne frazy. Jest to czyn nieuczciwej konkurencji, dzięki SEO Odkurzaczowi możliwe jest wyodrębnienie danych do postępowania cywilno-prawnego. Czarnego PR nie należy mylić z depozycjonowaniem – to są dwie podobne rzeczy, lecz mające zgoła inny charakter (cel). W pierwszym – obniżenie pozycji strony konkurencyjnej w wynikach wyszukiwania, w drugim – zdyskredytowanie firmy w świetle konsumentów (odbiorców).

Prezentacja SEO Odkurzacz

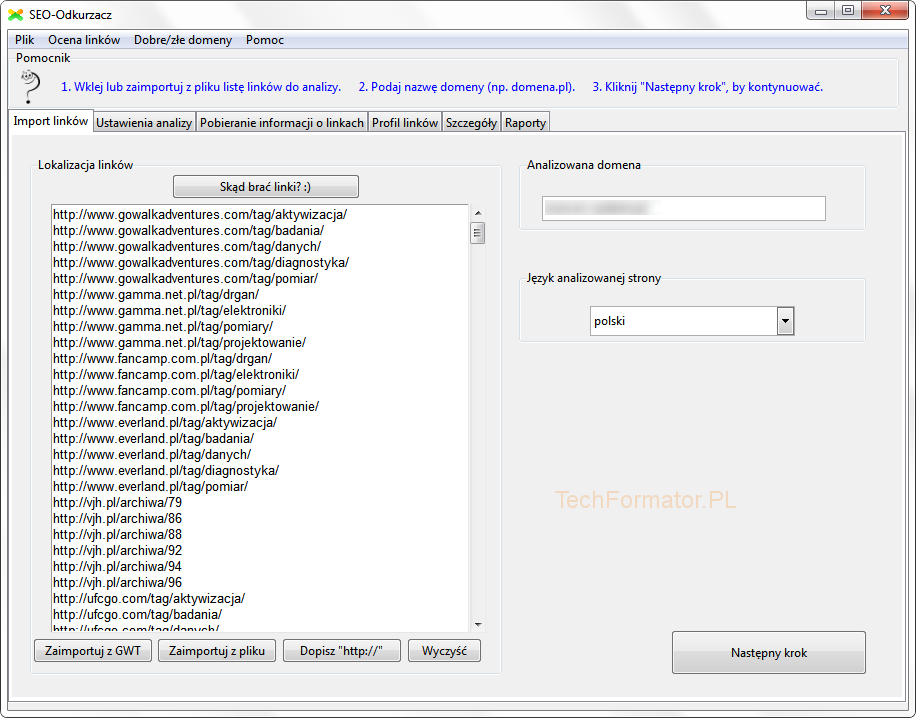

Aplikacja przywita nas zakładką Import linków. W tym miejscu użytkownik może pobrać dane wprost z Narzędzi Google dla webmasterów (Zaimportuj z GWT), wczytać dane z pliku lub wkleić odsyłacze wprost ze schowka.

Na tym etapie definiujemy również adres analizowanej domeny oraz deklarujemy język witryny. Szczególnie istotne jest podanie nazwy domeny. Nazwa nie może zawierać http://, należy podać nazwadomeny.pl lub z www, jednakże w tym drugim przypadku należy mieć na uwadze, że jeśli domena była linkowana z www i bez, to na wyjściu dostaniemy nieprecyzyjne dane. Z drugiej jednak strony czasem zachodzi potrzeba rozdzielenia adresów docelowych. Podanie prawidłowej nazwy jest wymagane między innymi do oszacowania, czy dany link występuje na danej stronie, czy też do wyliczenia statystyk w zakładce Profil linków. Przed przystąpieniem do kolejnego kroku upewnij się, że wpisałeś poprawnie nazwę domeny.

Takie funkcje jak Dopisz http czy szybkie wyczyszczenie danych również są przydatne – szczególnie pierwsza, albowiem jeśli adresy nie będą z http, aplikacja nie pozwoli przejść do kolejnego kroku – choć i tutaj jest drobny błędzik, albowiem na obecność http sprawdzany jest tylko pierwszy wiersz, pozostałe już nie. Aby rozwiązać problem, można byłoby sprawdzić każdy wiersz i wywołać komunikat tylko po co? Lepszym rozwiązaniem jest automatyczne dopisywanie http – tam gdzie go brakuje, na etapie przechodzenia do kolejnego kroku (po kliknięciu Następny krok), ale myślę że moje rady w tym zakresie są zbędne, autor programu nie jest amatorem i doskonale wie jak powinno wyglądać optymalne rozwiązanie.

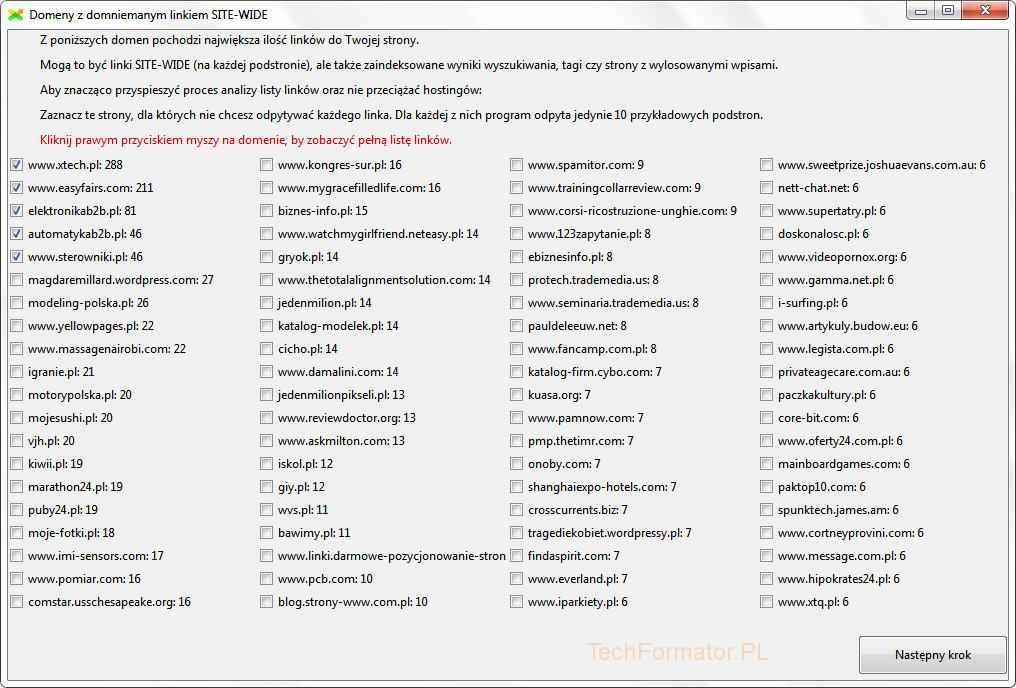

Wracamy do tematu przewodniego, po zdefiniowaniu wszystkich elementów przechodzimy do kolejnego kroku, w którym to pojawi się okno dotyczące domen z domniemanym linkiem SITE-WIDE.

W tym miejscu możemy odznaczyć/zaznaczyć część witryn, tym samym ograniczając lub zwiększając liczbę linków kwalifikujących się do analizy. Dla grupy zaznaczonych domen, podczas analizy zostanie odpytanych jedynie 10 pierwszych URLi.

Klikając prawym przyciskiem myszy na wybranej domenie, można poznać szczegóły – pełną listę linków. Po wywołaniu dodatkowego okna, program na tym etapie sprawdzi występowanie odsyłacza na stronie głównej (stąd drobne zawieszanie się okna).

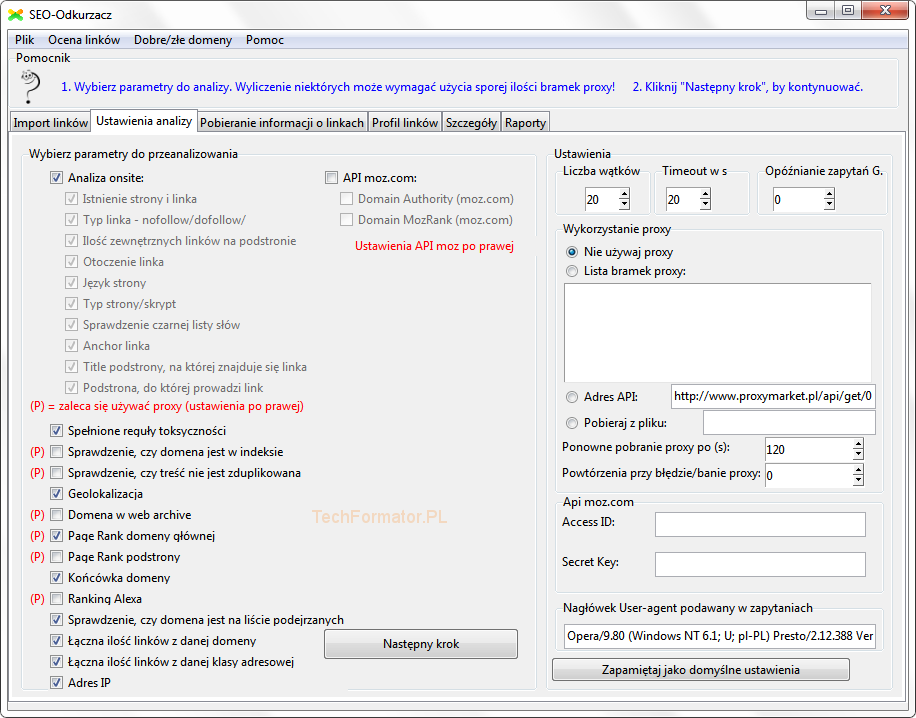

Klikamy Następny krok i przechodzimy do etapu Ustawienia analizy. W tym miejscu możemy określić zakres analizy. Analiza może dotyczyć czynników on-site, jak również off-site.

Atutem programu jest wielowątkowość. Bardzo szybka analiza, z zachowaniem wymaganej dokładności. Z kolei opóźnianie zapytań do Google kiedyś było skuteczne (aby zwiększyć skuteczność sprawdzania podobny system stosowałem w Google Index Checker), aktualnie ta funkcja minimalnie wpływa na żywotność proxy, tym bardziej, że aplikacja ogranicza nas do 15 sekund. Z tego co wiem Google ma teraz tolerancję w okolicach 5 minut, zatem żeby wyraźnie przedłużyć żywotność (opóźnić zbanowanie adresu IP), trzeba ustawić min. 300 sekund opóźnienia. Na takie coś nikt nie pójdzie, ponieważ jak łatwo policzyć czas analizy znacząco wydłuży się.

Możemy także zdefiniować listę adresów proxy. Nie wiem dlaczego autor używa sformułowania „bramka”. Z tego co wiem bramka proxy to jest skrypt PHP/CGI/ASP/PY (lub inny) instalowany na serwerze, adres w postaci IP:PORT powinien być określany mianem adresu proxy. Jeśli w przyszłości będzie funkcja sprawdzania via CGI/PHP proxy warto wprowadzić odpowiednie nazewnictwo, żeby wszystko było zrozumiałe.

Kolejna rzecz to pola adres API i pobieraj z pliku. Funkcje niezwykle przydatne, zachowując format proxy (IP:PORT) można wczytać adresy z praktycznie dowolnego API, polskiego, zagranicznego a nawet lokalnego.

Jak program rozrośnie się pola i funkcje można połączyć, sprawdzając obecność http IF-em, jeśli http wywołuj pobieranie pliku z hosta zdalnego, jeśli plik lokalny wywołaj drugą funkcję.

Swoją drogą lokalne scrapery i testery proxy z reguły są wywoływane na localhost z użyciem http://localhost/nazwapliku.txt (lub nazwapliku.php), tym bardziej, że wielu SEO speców podpina pod takie rzeczy VHOSTY (inaczej VirtualHost), wtedy nasz adres API przyjmuje postać np. http://proxyapi.loc/nazwapliku.txt

W każdym bądź razie, jak zabraknie miejsca, proponuję scalić pola tekstowe i zrobić sprawdzanie IF-em, którą funkcje użyć.

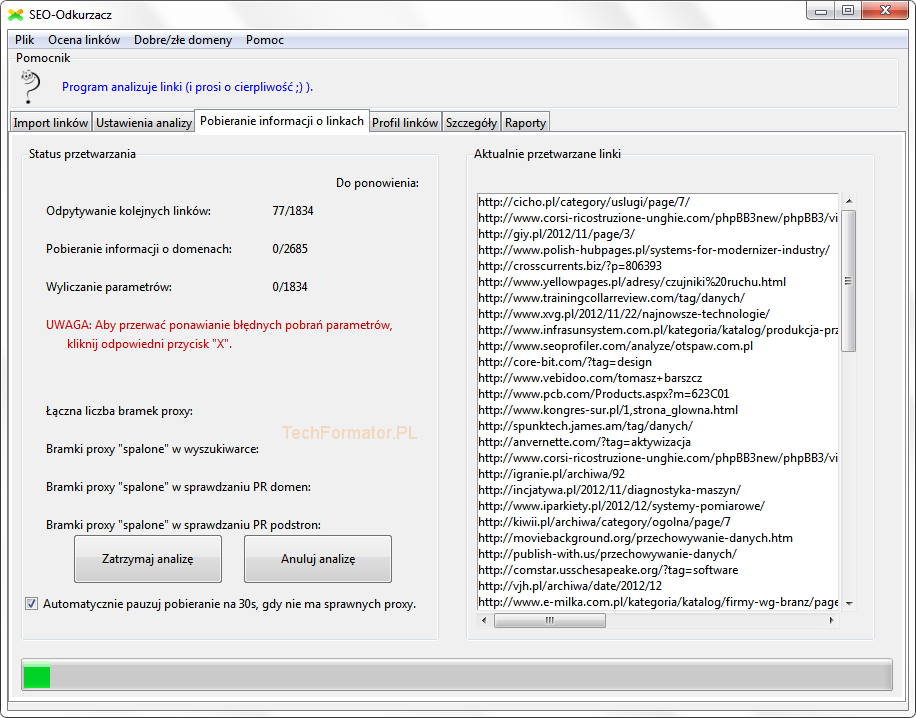

Ok, skonfigurowaliśmy ustawienia analizy, przechodzimy do następnego kroku, w którym to zostaną pobrane parametry i informacje o linkach. Ekran informacyjny jest całkiem dobrze skonstruowany, nie mam większych zastrzeżeń poza 2 kwestiami, drugą z nich przedstawię pod koniec recenzji, pierwsza poniżej.

Na tym etapie mamy zgrabną funkcję, mianowicie „Automatycznie pauzuj pobieranie na 30s… – tutaj dałbym użytkownikowi możliwość konfiguracji czasu opóźnienia, tak aby sam mógł wpływać na synchronizację pobierania nowych proxy z opóźnieniem. Być może domyślne ustawienia dobrze rozumieją się w przypadku API Proxymarket, gdzie czasy ponownego odpytania wynoszą 30-120 sekund. Wielu z nas nie używa tego systemu. Ta opcja wpływa bezpośrednio na czas analizy. Warto dać wybór użytkownikowi.

Zakończenie pobierania wszystkich danych zostanie zasygnalizowane stosownym komunikatem. Przechodzimy na zakładkę profilu linków.

Zobaczymy 3 pod-zakładki: Anchory, Geolokalizacja i języki oraz Strony, na których znaleziono linki. Można powiedzieć, że w tym miejscu znajdziemy przekrój profilu linkowania. Co warto tutaj dodać? Dodatkowe opcje do przekroju można zaciągnąć z Ahrefsa, Majestica czy LDX. Nie mówię tutaj o zaciąganiu danych „na żywca” (choć to też jest możliwe), tylko o wzorowaniu się na tych systemach. Posiadają ciekawe zestawienia, które przydają się podczas analiz.

Co jeszcze? Zobrazować część danych na wykresach np. procentowy udział anchor tekstu. Nie ma co się czarować, użytkownicy lepiej przyswajają dane w formie wykresów, aniżeli tabelek. Oczywiście nie jest to funkcja konieczna, zawsze można zrobić wykresy w arkuszu kalkulacyjnym, tym bardziej, że dane z tej zakładki można łatwo wyeksportować do XLS. Mimo wszystko, takie wodotryski podniosą wartość aplikacji.

Przechodzimy do kolejnej zakładki – Szczegóły. Tutaj znajdziemy wszystkie zebrane informacje.

Oznaczenie poszczególnych zmiennych jest dokładnie wyjaśnione, dostęp z poziomu aplikacji poprzez przycisk… Co oznaczają poszczególne kolumny.

W tej sekcji na szczególną uwagę zasługują:

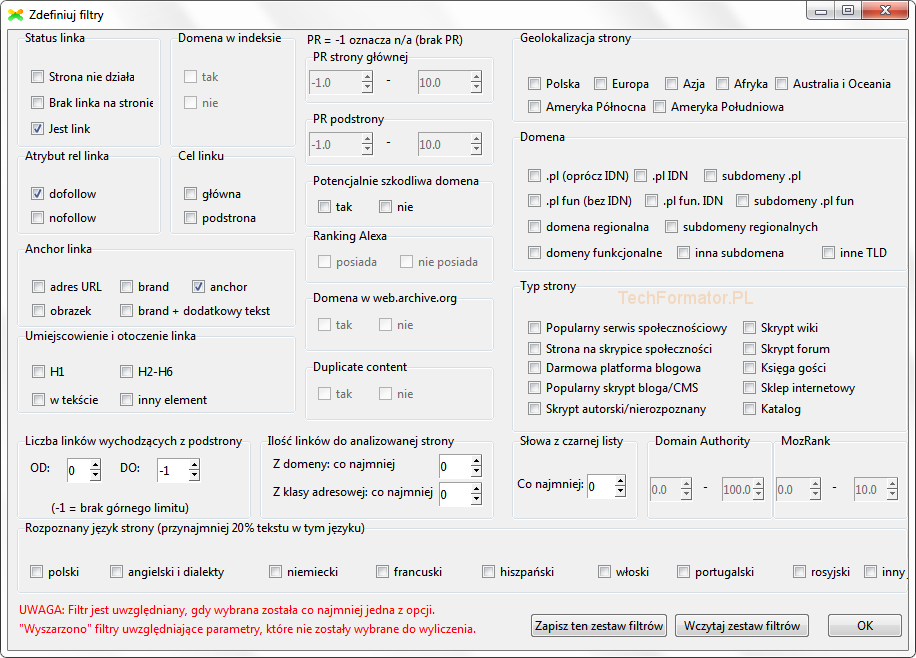

- Zaawansowane filtrowanie po linkach i anchorach,

- Reguły toksyczności (Reguły oceny linków),

- Dobre i złe domeny.

O każdym z elementów można przeczytać w dołączonej do programu instrukcji. Uwagi dla zakładki Szczegóły przenoszę na koniec artykułu.

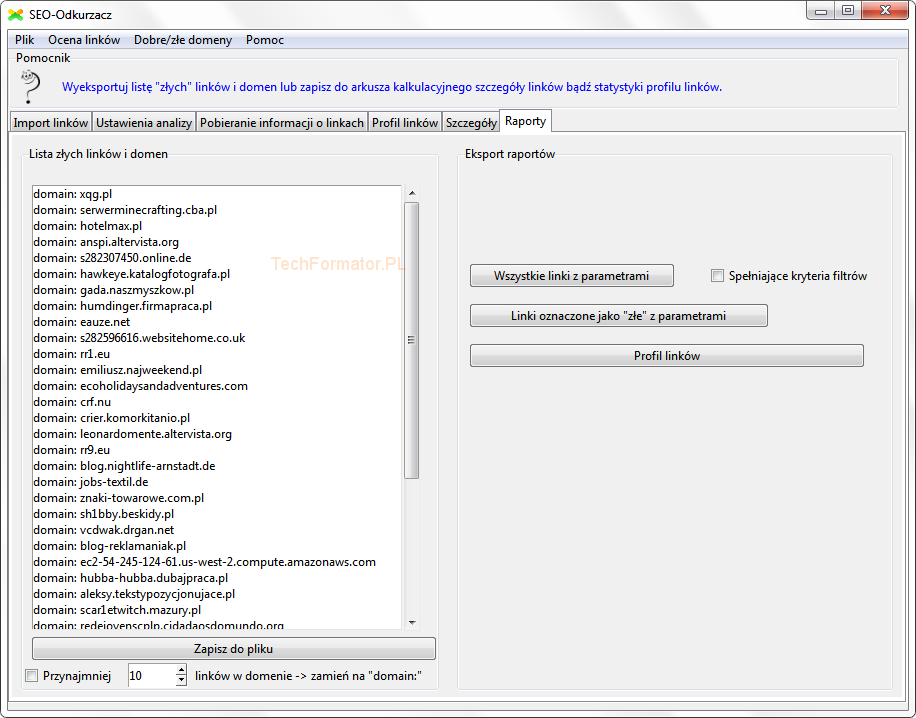

Ostatnia zakładka to Raporty. Znajdziemy tutaj powstałe po analizie dane, które posłużą do skonstruowania pliku disavow.

Oczywiście nie mogło zabraknąć opcji eksportu danych. Można zapisać wszystkie informacje z okna Szczegóły, bądź tylko te, które spełniają określone założenia.

Uff… kończę etap prezentacji i przechodzę do następnego rozdziału. Na zakończenie przedstawiam jeszcze filmik poglądowy ukazujący proces analizy linków.

Propozycje zmian

Wpierw przedstawię uwagi dla najistotniejszej zakładki – Szczegóły, następnie pod lupę pójdą pozostałe.

Punktowy system oceny toksyczności (poziomy toksyczności)

Uważam, że aktualna skala ocen linków jest niewystarczająca do swobodnej pracy. W wersji 1.1 użytkownik może oznaczyć link lub całą domenę jako złą, zatem do wyboru są tylko dwa warianty oceny – albo coś jest złe albo dobre. Niestety podczas wielu analiz przekonałem się, że takie wartościowanie linków nie ma racji bytu. Należy tutaj uwzględnić różne „odcienie szarości”.

Nie będę zagłębiał się w niniejszej recenzji w swoją metodologię pracy, natomiast na podstawie dotychczasowego doświadczenia zaproponuję na wstępie szalenie istotną opcję, mianowicie chodzi o ocenę toksyczności linków w skali definiowanej przez użytkownika np. od 0 do n, gdzie n przyjąć może wartość np. 3. Można uznać, że ów skala to nie ocena toksyczności, tylko skala prawdopodobieństwa toksyczności odsyłaczy. Musimy pamiętać, że żaden specjalista seo nie zna algorytmu Google i jest w stanie powiedzieć na 100% – tak ten link jest naturalny/nienaturalny. Możemy opierać się wyłącznie na prawdopodobieństwie toksyczności i w zależności od naszej oceny, odpowiednio przypisać analizowany przypadek do danego koszyka.

Przykładowe różnicowanie wartości odsyłacza w skali od 0 do 3 prezentuje się następująco:

- 0 – bardzo niskie prawdopodobieństwo naturalny link/dobra domena,

- 3 – szkodliwy link/domena do natychmiastowego odstrzału.

W podobnym tonie powinno być definiowanie bezpiecznych/szkodliwych domen. Również warto dodać tutaj wielostopniową skalę.

Własny zestaw kolorów dla poziomów toksyczności

Na przystawkę miło byłoby tutaj widzieć możliwość zdefiniowania własnych kolorów toksyczności dla każdego z „koszyków”. Przykładowe defaultowe kolorki…

- 0 – zielony

- 1 – żółty

- 2 – pomarańczowy

- 3 – czerwony

Dodatkowa kolumna „Uwagi”

Kolejna rzecz to dodatkowa kolumna, w której można będzie dopisać własne uwagi dla danego odsyłacza/całej domeny. Koniecznie kolumna/komórka, nie żadne dymki, podpowiedzi innymi słowy mówiąc komentarze znane z Excela. Wszystko musi być łatwo dostępne, sortowalne (klasycznie i przez filtr) oraz oczywiście ów dane muszą być zapamiętane w programie (zapis do pliku LKS).

Oznaczanie przejrzanych linków

Wyniki można dowolnie sortować, filtrować, jako że aplikacja nie pamięta poprzedniego stanu przeglądu po takowym przefiltrowaniu dochodzi do przestawienia wierszy, przez co użytkownik traci orientację. W moim przekonaniu, aplikacja winna być bardziej przyjazna dla użytkownika, powinna ułatwiać orientację. Do oznaczania linków można wykorzystać system punktowy – byłoby to najlepsze rozwiązanie. Obecny system 2-stopniowej skali (dobry/szkodliwy) jest niewystarczający.

Większa swoboda w zarządzaniu kolumnami (elastyczna prezentacja wyników)

Następna szalenie istotna opcja wpływająca na usability – możliwość ukrywania wybranych kolumn i ich dowolnego „ustawiania” (przesuwania). Do tego zapamiętywanie tych ustawień i odtwarzanie podczas wczytywania projektu. Aktualnie w widoku szczegółów są elementy, które często nic nie wnoszą do analizy, żeby ukryć część kolumn trzeba bawić się suwakiem a i to nie da się w pełni schować danych z kolumny. Użytkownik powinien mieć swobodę wyboru kolumn i jednocześnie elementów, na podstawie których będzie oceniał strony/odsyłacze.

Należy pamiętać również, że nie każdy z nas posiada monitor z magiczną rozdzielczością 1920×1080 albo i większą, dzięki której wszystkie niezbędne dane będą dobrze widoczne na ekranie. Wiele osób pracując na laptopach musi iść na kompromis. Wedle mojej opinii taka funkcja musi być wdrożona. Obecnie na analizę danych traci się zbyt wiele czasu, przez co lepiej jest skorzystać z arkusza kalkulacyjnego, aniżeli analizować wszystko bezpośrednio z poziomu okna SEO Odkurzacza.

Otwieranie kilku linków jednocześnie

Możliwość otworzenia kilku linków jednocześnie w przeglądarce. Zaznaczenie z użyciem CTRL/SHIFT kilku odsyłaczy, wywołanie stosownej opcji i w konsekwencji otwarcie wskazanych linków w nowych kartach przeglądarki. Na tę chwilę aplikacja potrafi otworzyć nie więcej niż jeden link na kliknięcie. Żeby otworzyć większą liczbę, trzeba przeklikiwać każdy z wierszy. Wypadałoby wprowadzić usprawnienie w tym zakresie, które skróci czas pracy i zwiększy komfort przeglądania.

Rozszerzona obsługa skrótów klawiaturowych

Dla wszystkich ważniejszych funkcji podpiąć skróty klawiaturowe np. podobnie jak jest z funkcją Pokaż szczegóły linka, która jest wywoływana skrótem klawiaturowym (spacją).

Wprowadzenie/Rozszerzenie funkcji kopiowania

Użytkownik powinien mieć możliwość skopiowania dowolnej wartości z tabeli komórki np. adres IP, title.

Możliwość łatwego podglądu danych WHOIS

Klikalna komórka adresu IP – po wykonaniu akcji (dwuklik) przeniesienie na stronę z Whois (serwis definiowany przez użytkownika). Użytkownik może skopiować adres IP/domenę z okna Szczegóły i wkleić do odpowiedniego pola na stronie. Ewentualnie wdrożenie funkcji, która pokaże w odrębnym oknie szczegóły dotyczące serwera, jednakże to wiem z doświadczenia że nie jest takie proste, wiele serwisów ma ograniczenia, zabezpieczenia captcha i inne.

Zwiększenie liczby parametrów

Podpięcie Majestic SEO i Ahrefs API. Wiem że z racji kosztów, na początku może stanowić to spore wyzwanie. Dwie opcje pobierania statystyk, przez API i klasycznie. Klasyczne scrapowanie będzie wymagało proxy, zatem warto dać wybór użytkownikowi, czy chce ponosić koszty dodatkowych serwerów pośredniczących, czy też wykupić dostęp do konta z API.

Domyślne wyśrodkowanie okien

Dla wszystkich formatek ustawiłbym otwieranie domyślne jako center parent, żeby nie było sytuacji, w której okno otwiera się poza widocznym obszarem (poza ekranem). Podczas użytkowania aplikacji miałem taką sytuację, dlatego o tym wspominam.

Konfigurowalne cache

Aktualnie aplikacja przechowuje dane w lokalizacji TMP. Być może się mylę albo i nie, z tego co widzę, autor programu w ten sposób robi optymalizację użycia pamięci operacyjnej, przerzucając część rzeczy do cache i wykonywaniu „obliczeń” na żywym organizmie. Optymalizacja całkiem niegłupia, ale zapomniano o jednej istotnej kwestii – pojemności dysku twardego i możliwości wyczerpania się wolnego miejsca.

Co się stanie jak zabraknie wolnej przestrzeni dyskowej? Cóż… zrobiłem eksperyment, postawiłem 40MB ramdysk, umieściłem w nim katalog z aplikacją. Gdy wolne miejsce skończyło się, program przerwał analizę. Każda nowa próba przeanalizowania czegokolwiek kończyła się fiaskiem.

Jeśli ktoś wykonuje wiele analiz (jak ja) cache rośnie w zastraszającym tempie (u mnie na dysku jest już ponad 3GB danych w TMP). Warto pozwolić użytkownikowi na wybranie własnej lokalizacji zapisu, przenieść TMP na przykład, na inny pojemniejszy dysk twardy lub do pamięci ulotnej – ramdysku.

Pojawia się w tym miejscu jeszcze kilka pytań, jakie jest zadanie (oprócz optymalizacyjnego) takiego rozwiązania? Czy ów dane wykorzystywane są przy kolejnych analizach? No cóż, nie znam odpowiedzi na te pytania, przez co nie mogę doradzić optymalnego rozwiązania. Być może autor po przeczytaniu recenzji uroni rąbka tajemnicy.

Moduł wykrywający przekierowania

W zamierzchłych czasach jedną z metod pozycjonowania, która dobrze sprawdzała się było „pozycjonowanie na przekierowania”. W dużym skrocie – chodzi o pozycjonowanie stron „córek” i późniejsze przekierowanie zdobytej „mocy” na stronę docelową. W takiej o to sytuacji po pewnym czasie od założenia przekierowania, linki strony przekierowanej pojawiały się w wykazie w Narzędziach dla webmasterów strony docelowej.

Cała idea tego modułu, polegałaby na próbie wykrycia takich sytuacji (przekierowań). Nie jest to proste, lecz możliwe. Z reguły klienci wiedzą jakie grzechy mają na sumieniu, wiedzą również jakie domeny przekierowywali na stronę docelową – można to wykorzystać w skonstruowaniu mechanizmu detekcji. Zatem, rolą modułu byłoby wyodrębnienie wszystkich tych lokalizacji (linków), które wpasowują się idealnie w ten typ pozycjonowania.

Wykrywanie SWL

Moduł wykrywający prawdopodobieństwo wystąpienia SWL na stronie. Już teraz na podstawie dostępnych w Odkurzaczu parametrów można oszacować, czy mamy SWL na stronie/podstronie, jednakże aby zwiększyć skuteczność wykrywania trzeba by iść o krok dalej i zbudować mechanizm wykrywania z prawdziwego zdarzenia. Nie będę się w tej kwestii rozpisywał, żeby nie zdradzać właścicielom SWL zbyt wiele. Taka funkcjonalność w SEO Odkurzaczu byłaby mile widziana.

Korekta opcji spełnione reguły toksyczności

Umieszczenie opcji Spełnione reguły toksyczności na etapie ustawień analizy jest kiepskim rozwiazaniem. Dlaczego? Jak user pominie tę opcję, a później będzie chciał wrócić do tego rozwiązania zawiedzie się. Aby skorzystać z tej opcji będzie musiał ponownie przeprowadzić całą analizę. Więc albo ów opcje przełączyć w tryb disabled – tak aby nikt nie mógł tej opcji ruszyć, albo całkiem ją usunąć, bądź też zaimplementować ją dalej – na zakładce Szczegółów.

Zaawansowany moduł proxy

Scrapowanie, testowanie i podstawianie serwisów proxy „w locie” – chyba nic tutaj nie trzeba dodawać. Mechanizm znany z niektórych aplikacji, ceniony. Oczywiście skuteczność uzależniona od list użytych do scrapowania.

Idąc dalej tym tropem, proxy wczytywane z wielu lokalizacji jednocześnie. Mamy kilka dostępów do API, z różnych systemów, chcielibyśmy wykorzystać wszystkie adresy. Może warto pomyśleć nad takim udogodnieniem? Jeśli mamy API, które generuje plik TXT lub na czysto w PHP, można użyć mechanizmu scrapera do pozyskiwania danych z takich lokalizacji.

Dodatkowe uwagi dotyczące wyświetlanych parametrów

Rozkład linków w czasie

Pobieranie timestamp (data i czas wpisu) page/subpage (o ile timestamp dokumentu istnieje), ale to już służy do zaawansowanych analiz, gdy trzeba zebrać dowody przeciwko osobom, które dopuszczają się depozycjonowania. Funkcja stanowiłaby ułatwienie wyodrębniania tego typu danych.

Również pomogłoby to sprawdzić rozkład indeksacji w czasie. Jak wiemy pobranie danych o dacie indeksacji choćby z Google cache, często nie ma przełożenia na fakty – dane bywają mylące, jednakże mimo wszystko da się wyodrębnić informacje, które można wykorzystać w toku zaawansowanych analiz. Zatem podsumowując ten punkt, pobieranie timestamp dokumentu, na którym odnaleziono link plus sprawdzanie daty indeksacji, a w zasadzie jak już wcześniej napisano, ostatni zrzut strony.

Alternatywna metoda ustalania wieku domeny

Dodanie odpytywania serwisów WHOIS w celu ustalenia daty rejestracji domeny. Miło byłoby jak aplikacja będzie zbierać dane końca okresu rozliczeniowego, różnica między datami wyrażona w dniach także prezentowana użytkownikowi. Oprócz tego pozyskanie danych abonenta (tam gdzie to możliwe, istotne jest imię i nazwisko oraz adres e-mail) oraz nazwę rejestratora domeny. Wiem, że pozyskanie danych nie jest proste, dane z DNS.pl zabezpieczone kodem captcha. Są inne serwisy, lecz nie są aż tak precyzyjne jak informacje wprost z krajowego rejestru domen.

Można wykorzystać inne serwisy np. domeny_pl/whois.html tę prostą captchę można rozwiązać nawet przy pomocy ImageMagick, ewentualnie poprzez systemy zewnętrzne, ale i tak pozostanie kwestia proxy. Mimo wszystko moduł do pozyskiwania danych kontaktowych do właścicieli witryn byłby ciekawą funkcją. Warto pomyśleć o tym.

Uwagi dla zmiennych w widoku Szczegóły

Zmienna PAGE_LANGUAGE – rozbieżności w wykrywaniu lang między stroną główną a podstroną. Spotkałem się z sytuacjami, w których język był nieprawidłowo raportowany. Nie wiem w jaki sposób autor wyodrębnia język, pewnie część algorytmu bazuje na ocenie występujących w kodzie witryny zmiennych typu lang=”pl”, content=”pl” czy charset/encoding (kodowanie, w przypadku PL – iso-8859-2), który jest charakterystyczny dla niektórych typów języków. Może jednak warto dodatkowo zastosować NLP lub prosty OCR wykrywający charakterystyczne dla danego języka znaki diakrytyczne?

Oprócz tego warto wdrożyć do aplikacji podział, na PAGE LANG i LANG wykryty na konkretnej podstronie. Oczywiście mam świadomość, że to wymaga dodatkowej „mocy obliczeniowej”, jednakże taka opcja powinna znaleźć się w programie, najlepiej w pełni konfigurowalna, gdzie user decyduje czy przeprowadzić dodatkową analizę.

Zmienna EXTERNAL – w założeniu ma pokazywać liczbę wychodzących linków i pokazuje, jednakże tutaj również przydałby się większy podział. Jeśli ktoś przy ocenie linków będzie kierował się tym parametrem oceniając choćby możliwość wystąpienia SWLa na stronie, prędzej czy później mocno się przejedzie, albowiem aktualnie SEO Odkurzacz wszystko wrzuca do jednego worka, klasyfikując linki kierujące do subdomen na równi z linkami wychodzącymi do całkowicie innych domen – tak nie powinno być. Należy wprowadzić dodatkowy podział na: Liczbę wszystkich linków wychodzących, Liczbę linków do subdomen domeny, Liczbę linków do zewnętrznych domen.

Zmienna SCRIPT – niestety bardzo często zbyt ogólnikowe informacje, które kompletnie nie pomagają. Proponuję wprowadzić moduł rozpoznawania skryptów na podstawie custom footprints, które będą definiowane przez użytkownika. Rozwiązanie może być proste, choćby na wzór znanej darmowej aplikacji Sick Platform Reader, gdzie użytkownik edytując plik filter.txt może dodać własne footprinty, zwiększając tym samym skuteczność rozpoznawania typu skryptu. Oczywiście nie mówię o takim samym schemacie. Warto wdrożyć system, w którym to użytkownik zdecyduje o poziomie skuteczności. Wielu z nas ma swoje listy footprintów, przetestowane i skuteczne. Taka elastyczność w tym zakresie byłaby dużym atutem aplikacji.

Zmienna DOMAIN_PR – wszystko byłoby jak w najlepszym porządku, gdyby nie powielony z innych aplikacji schemat sprawdzania i serwowania wyników. Nie wiem czemu wszyscy developerzy idą na łatwiznę. Czy nie stać ich na innowacyjne podejście?

PageRank jest jednym z tych parametrów, który nie zmienia się zbyt często, przez co doskonale nadaje się do optymalizacji. Zatem dlaczego nie wdrożyć dla niego mechanizmu polegającego na cachowaniu wyników i dostarczaniu użytkownikowi danych z cache?

Proszę sobie pomyśleć ileż to czasu zostanie zaoszczędzone na odpytywaniu serwisów. Dodam że żadna aplikacja desktopowa jaką testowałem nie posiadała takiego rozwiązania. Warto wdrożyć zaawansowany mechanizm pobierania, odświeżania i przechowywania parametrów, które mają niskie tempo zmiany w czasie. Dzięki temu rozwiązaniu aplikacja może być najlepsza na świecie w swojej klasie. Takie rozwiązanie niesie ze sobą wiele problemów natury programistycznej i nie tylko, lecz w mojej ocenie warto spróbować takiego „innowacyjnego” podejścia podczas optymalizacji aplikacji.

Zmienna BLACK_WORDS – uwagi mam podobne jak do wykrywania typu skryptu. Możliwość dowolnego konfigurowania listy „napiętnowanych” słów kluczowych będzie kolejnym atrybutem, który podniesie użyteczność i elastyczność aplikacji.

Pozostałe bugi i usprawnienia

- Podczas wczytywania projektu wyskakuje błąd Scrolled TreeView object is not callable. Error nie występuje na czystym projekcie. Z tego co widzę bug dotyczy kontrolek w zakładce „Profil linków”.

- Usterka z filtrowaniem wyników. Wygląda na to, że aplikacja ma problemy z polskimi znakami w anchorze.

- Aplikacja ma problem podczas wczytywania projektów jeden po drugim. W pewnym momencie następuje błąd odczytu i komunikat „string index out of range”. Problem występuje tylko wtedy, gdy w bieżącym projekcie jest aktywne filtrowanie danych (w zakładce Szczegóły).

- Gdy anulujemy pobieranie informacji o linkach pasek postępu nie zostaje wyzerowany.

- Możliwość zaznaczenia danych w polach tekstowych poprzez użycie skrótu CTRL+A.

- W oknie domeny z domniemanym linkiem site-wide przydałyby się opcje umożliwiające odznaczenie/zaznaczenie wszystkich checkboksów, bądź też odwrócenie zaznaczenia lub zaznaczenia tylko tych, które spełniają odpowiednie kryteria np. zaznacz wszystkie gdy liczba odnalezionych linków większa od 20.

- Przy sprawdzaniu parametrów możliwość użycia bramek CGI/PHP proxy (np. Glype), bądź realizacja odpytywania na wzór serwisu Serpmonster, gdzie użytkownik wgrywa na swoje serwery odpowiednio spreparowane skrypty, które pośredniczą w odpytywaniu Google.

- Poprawienie szerokości kolumn w arkuszu eksportu XLS. Wiele kolumn posiada nieadekwatną szerokość do zawartości np. SUSPICIOUS czy FROM_IP_CLASS.

- Na karcie Raporty, gdy anulujemy zapis/eksport danych pojawia się błąd „Errno 22 invalid mode”.

- W części przypadków dane w kolumnach nie mają wystarczająco dużych marginesów, przez co informacje są nieczytelne.

- Wdrożenie odrębnych narzędzi np. do sortowania/filtrowania danych z disavow, moduł podobny do ostatnio omawianej aplikacji List Compare Buddy.Dla przykładu, otrzymujemy od klienta linki lub stary disavow, chcemy go przefiltrować, porównać z tym co aktualnie jest w Majesticu i/lub Google Webmaster Tools, bądź też wyodrębnić unikalne linki które występują w Majestic SEO, a których nie ma wylistowanych w GWT. Taki dodatkowy oręż byłby niezwykle pomocny w trakcie pracy z listami.

Pozostałych propozycji (a zostało trochę tego) nie będę opisywał w aktualnej edycji i tak z tej recenzji zrobił się niezły tasiemiec. Nie wiem czy ktokolwiek z Was wytrwał do końca. Tym którym udało się gratuluję.

Jak zauważyliście, szczególny nacisk położyłem nie na zaprezentowanie możliwości programu, lecz na przedstawienie propozycji zmian. Jeśli autor wdroży choć część z nich, myślę że SEO Odkurzacz nie będzie miał sobie równych w Polsce i na świecie.

Swoją drogą kolejnym etapem rozwoju aplikacji (gdy już zostaną wyeliminowane wszystkie błędy i wdrożone poprawki związane z usability) powinna być ekspansja na zachodnie rynki i translacja interfejsu aplikacji – przynajmniej język angielski. Jeśli zajdzie potrzeba mogę pomóc w tłumaczeniu interfejsu. Mam już w tym spore doświadczenie.

A Ty jaką masz propozycję ulepszeń? Podziel się swoją opinią w komentarzu…

Jeśli chcesz abym przetestował Twoją aplikację i napisał o niej recenzję, skontaktuj się ze mną poprzez e-mail lub zostaw wiadomość online…

UWAGA! Napisanie dobrej, rozbudowanej recenzji (jak ta) kosztuje wiele wysiłku i czasu, z racji ograniczonych zasobów czasowych tylko najbardziej perspektywiczne projekty mają szansę zaistnieć na tym blogu.

Podsumowanie

Dobrnęliśmy do końca, czas na wnioski i ocenę aplikacji.

Cena

Aktualna cena programu wynosi 65zł (dla wersji 1.1) – w porównaniu do innych konkurencyjnych systemów, cena jest bardzo atrakcyjna i adekwatna do oferowanych funkcji. Mimo że mam wiele zastrzeżeń do programu, nie mogę dać innej oceny jak 4.8 – niższa byłaby wysoce krzywdząca. Analizując ceny największych konkurentów i funkcjonalności ich systemów, tak wysoka ocena seo odkurzacza jest uzasadniona i w pełni odzwierciedla stosunek ceny do jakości. Aplikację możesz zakupić w sklepie internetowym lub poprzez e-mail. Szczegółów szukaj na stronie NanoMedia.

Stabilność

Jedna z osób wypowiadała się swego czasu, że piętą achillesową SEO Odkurzacza jest stabilność. Po gruntownych testach mogę śmiało powiedzieć, że to jest naciągana opinia. Aplikacja w trakcie analizy (bez proxy) ani razu nie wyłożyła się – nie doszło do błędu krytycznego, w którym użytkownik byłby zmuszony zabić proces aplikacji lub był zmuszony do zrestartowania programu. Faktycznie logika aplikacji może w pewnych scenariuszach spowodować trudności w użytkowaniu, jednakże nie uważam, by soft zasługiwał na tak pogardliwą ocenę. Oczywiście są bugi, jak choćby problem ze wczytywaniem danych, zawieszenia formatek podczas wykrywania linków sitewide czy w trakcie błędu pobierania listy proxy, które obniżają ogólną ocenę. Mimo niedociągnięć uważam, że stabilność aplikacji jest całkiem wysoka – dla wersji 1.1 przyznaję notę 3.9.

Wygląd

Dla wielu z nas wygląd aplikacji nie ma najmniejszego znaczenia, lecz udowodnione jest, iż aplikacje wyposażone w ładny interfejs sprzedają się lepiej. Cóż mogę powiedzieć… SEO Odkurzacz posiada interfejs na poziomie niższym od „średniej krajowej”. Wygląd niektórych elementów przypomina czasem bałagan w pokoju dziecka, wszystko porozrzucane bez ładu i składu. Przydałoby się porozmieszczać należycie tabelki, z odpowiednim wyjustowaniem, ogarnąć przyciski i inne elementy interfejsu – mając na uwadze nie tylko sam wygląd, lecz również rozważne rozmieszczenie funkcji, tak by usability interfejsu stało na wysokim poziomie. Moja ocena w kwestii wyglądu trója z minusem – w przełożeniu na system punktowy ocena 2.9. Mam nadzieję, że autor ogarnie nieco interfejs.

Użyteczność

Na użyteczność składa się wiele czynników, między innymi: rozmieszczenie przycisków, łatwość operowania funkcjami, sposób prezentacji danych jak również dodatkowe zaawansowane funkcje, ułatwiające pracę z danymi. SEO Odkurzaczowi nie można odmówić funkcjonalności, znacząco upraszcza cały proces pozyskiwania i filtrowania danych. W porównaniu do innych metod półautomatycznych (których używałem wcześniej), wyraźnie skraca proces pozyskiwania danych o dobre kilka godzin. Największym atutem obecnej wersji jest moduł filtrowania danych. Można nawet powiedzieć, że to jest serce aplikacji, coś co sprawia, że użytkownik oszczędza na analizie kilka cennych godzin. Jednakże samo zaawansowane filtrowanie nie wystarczy.

Podczas prawie 2-miesięcznych testów wyszło wiele mankamentów, które uniemożliwiają w pełni komfortowe użytkowanie programu – głównie mowa o sposobie prezentacji danych. Użytkownik ma ograniczone możliwości wpływania na to, jakie dane są wyświetlane w kolumnach, nie można ich całkowicie ukryć, również sortowanie poprzez kliknięcie w nagłówek kolumny sprawia problemy. Aktualnie żeby coś solidnie przeanalizować, użytkownik jest wręcz zmuszony, do przeniesienia części procesu analizy do zewnętrznych narzędzi – mowa oczywiście o arkuszu kalkulacyjnym.

Mając na uwadze wszystkie za i przeciw w kategorii „Użyteczność” muszę wystawić Odkurzaczowi niską ocenę – 2.8, która mimo wszystko oddaje realną użyteczność programu – aplikacja dobra jest do pozyskiwania i filtrowania danych, jednakże przeprowadzenie analizy od A do Z bezpośrednio z poziomu programu, wedle mojej oceny jest utrudnione. Brakuje również kilku istotnych funkcji pomagających w ocenie toksyczności linków oraz występują niedomówienia w pewnych kwestiach (zmiennych).

Teraz pewnie u wielu użytkowników zapanowała konsternacja. Nie stresujcie się tak. Na tle konkurencji ocena 2.8 i tak nie jest zła. Gdybym recenzował inne softy w tej kategorii (pod kątem oceny toksyczności) – oceny ich użyteczności byłyby jeszcze niższe.

Użyteczność obok stabilności jest najważniejszą kwestią w tego typu oprogramowaniu. Mam nadzieję, że autor weźmie sobie do serca moje uwagi, wprowadzi dodatkowe funkcje i wyeliminuje niedociągnięcia, dostarczając tym samym wysokiej jakości aplikację, która zdobędzie uznanie użytkowników nie tylko w Polsce, lecz również i za granicą. Na zmianach wszyscy skorzystamy.

Czy warto zainwestować w tę aplikację? Odpowiadam – TAK. Cena jest niezwykle atrakcyjna w porównaniu do innych narzędzi tego typu. Sama aplikacja może okazać się czarnym koniem wszelkich SEO narzędzi – w tej chwili nie jest najładniejsza, jest trochę bugów, brakuje wielu funkcji, lecz w przyszłości może skutecznie „wykurzyć” konkurencję.

Testy SEO Odkurzacza przeprowadzałem na Windows 7 64-bit.

| Parametr | Ocena |

| Stabilność | 3.9 |

| Użyteczność | 2.8 |

| Wygląd | 2.9 |

| Cena | 4.8 |

| Razem | 14.4 |

| Średnia ocena | 3.6 |

Mariusz wielkie dzięki za recenzję kolejnego narzędzia 🙂 Długo wyczekiwałem na ten artykuł, ponieważ przydałby mi się sprawdzony soft do gruntownej analizy linków, który nie jest zbyt drogi, a posiada najważniejsze funkcjonalności. Ciekaw jestem, czy twórcy programu wezmą pod uwagę Twoje pomysły, bo z pewnością program byłby jeszcze bardziej atrakcyjny, nawet jeśli jego cena by wzrosła.

PS. Jest może jakaś wersja trialowa SEO Odkurzacza?

Jest tylko lub aż wersja demonstracyjna, ale demo pozwala jedynie sprawdzić domeny zaczynające się na literkę „a”, poza tym demo nie traci na funkcjonalności więc można zobaczyć co w trawie piszczy.

Mariusz zrobił kawał nieprawdopodobnej roboty! Jestem pełen podziwu dla takiej sumienności.

Bardzo dużo jeszcze można zrobić, świetnie wypunktowane zostały mankamenty narzędzia (z którymi zgadzam się prawie w 100%) i propozycje rozwoju. Nie pozostaje mi nic innego, tylko zrobić z nich dobry użytek w kolejnych aktualizacjach! Cieszę się też, że zostały zauważone atuty programu – czasami wyobrażenie autora programu na temat tworzonego narzędzia rozmija się z tym, jak je widzą Użytkownicy, a przecież to dla nich ma mieć ono realną wartość!

Gdyby ktoś miał pytania dotyczące programu – zapraszam do kontaktu, postaram się odpowiedzieć.

Na trzy wątpliwości, które pojawiły się w tekście już mogę odpowiedzieć: 🙂

– odnośnie „czarnych słów”: własne wyrażenia regularne można definiować w pliku: my_blacklist.txt 🙂

– jeśli chodzi o rozpoznawanie języka – program wykorzystuje modele statystyczne w odniesieniu do tekstów na stronie

– jeśli chodzi o katalog na pliki tymczasowe „tmp” – jest on czyszczony po każdej analizie, program używa go do zapisywania na jej czas plików ze źródłem HTML stron.

Jeszcze raz dziękuję Autorowi recenzji,

Pozdrawiam serdecznie,

Damian

@Damian Kiełbasa, u mnie chyba jakiś bug jest bo z każdym kolejnym projektem TMP rośnie i po zamknięciu programu ani przy nowym uruchomieniu projektu dane nie są czyszczone. Muszę to dokładniej sprawdzić.

Zapomniałem jeszcze dopisać w recenzji o jednej ważnej funkcji, mianowicie o auto-zapisywaniu całego projektu LKS co zadaną liczbę minut. Ścieżka i odstęp czasowy definiowane przez użytkownika. Bo teraz wygląda to tak, że jeśli user nie zapisze projektu, to straci część danych np. pracując na stacjonarnych kompach bez UPS’a jak odetniemy prąd to po zawodach, musimy zacząć analizę od miejsca, w którym wczytaliśmy projekt. Mnie akurat problem nie dotyczy bo odkurzacza używam na lapku, który zwykle jest z włożoną baterią, ale osoby na stacjonarnych kompach mogą mieć problem.

Testowałem to narzędzie w wersji demo.

Bardzo fajnie omówiłeś i mocno zastanawiam się nad kupnem bo cena jest śmieszna a powinno pomóc oczyścić mi profil linków.

W sumie Mariusz to bardzo fajnie, że napisałeś taką recenzję, przedstawiłeś opcje poprawek, rozszerzenia softu, etc to z pewnością poprawi soft. Ale jak dla mnie i pewnie znajdzie się wielu użytkowników odkurzacza tyle opcji nie jest potrzebne, bo zna się mniej więcej profil linków stron nad którymi się pracuje. Osobiście filtruje według jednego kryterium link: DF, jest, przez co nie zawracam sobie głowy tym co jest NF i tym czego nie ma. Zostają linki których toksyczność, wartość, etc każdy seowiec chce ocenić sam, bo jak wiemy zostanie jeden zły link i ma się 3 tyg. w plecy. Recenzja przydługawa, precyzyjna ale fajna 😉

Kupiłem program i muszę powiedzieć, że jestem bardzo zadowolony. Bardzo szybko „pali” proxy, ale to nie wina programu. Cena nie jest zbyt wygórowana, a sam program bardzo intuicyjny. Po przeczytaniu tej recenzji oraz instrukcji nawet amator poradzi sobie z obsługa. Druga kwestią jest wyciąganie wniosków na podstawie analizy.