Podczas procesu pozycjonowania stron niezwykle istotnym etapem jest analiza, czy wpisy w katalogach, preclach, blogach zostały zauważone przez Google – inaczej mówiąc, czy znajdują się w indeksie wyszukiwarki. W celu automatyzacji tego procesu postanowiłem stworzyć własne narzędzie, które w sposób efektywny sprawdzałoby stopień indeksacji. Program dostępny za darmo dla wszystkich fanów TechFormator. Kliknij Lubię to! i zdobądź aplikację.

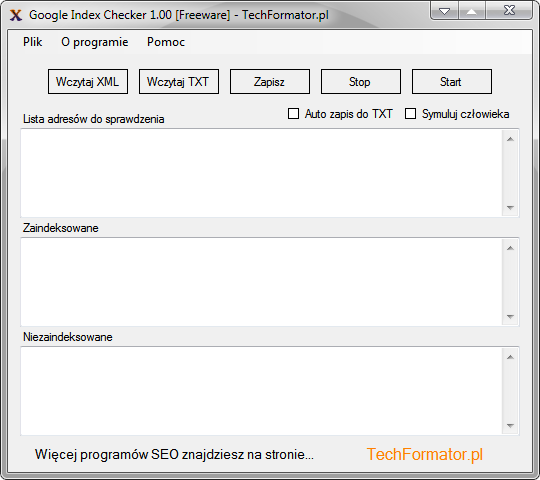

Google Index Checker – prezentacja programu

UWAGA! Program wymaga podania hasła dostępu. Każdy z Was, kto polubił witrynę techformator.pl może pobrać darmowy kod z fanpejdż (sekcja Free Seo Tools).

Okno główne Google Index Checker podzielone jest na cztery sekcje.

Na samej górze znajdziemy kluczowe funkcje programu takie jak:

- Wczytaj XML – wczytuje zestaw adresów z pliku XML, może to być mapa witryny (sitemap.xml) lub inny plik w formacie XML. Zostaną wczytane tylko te dokumenty, które zostały przygotowane zgodnie ze standardami.

- Wczytaj TXT – wczytuje linki z pliku tekstowego.

- Zapisz – pozwala zapisać dane do dwóch niezależnych plików tekstowych (strony zaindeksowane, niezaindeksowane). Ścieżka definiowana przez użytkownika.

- Stop/Start – zatrzymuje/uruchamia proces sprawdzania.

- Auto zapis do TXT – automatycznie zapisuje wyniki do plików tekstowych (zaindeksowane.txt, niezaindeksowane.txt), pliki powstaną w głównym katalogu programu.

- Symuluj człowieka – wprowadza czas opóźnienia między kolejnymi zapytaniami kierowanymi do wyszukiwarki. Opcja zmniejsza częstotliwość wykonywania zapytań, co minimalizuje ryzyko nałożenia restrykcji na adres IP komputera. Przydatna gdy mamy do sprawdzenia dużą pulę adresów.

Google Index Checker uzyskuje skuteczność klasyfikacji na poziomie 99% (Google.pl). Dotychczas najlepsze darmowe narzędzia SEO uzyskiwały wyniki na poziomie 76-87%.

Wymagania:

- System operacyjny XP, Vista, Windows 7 32/64-bit lub Linux ze środowiskiem Wine i wgranymi bibliotekami środowiska Microsoft .NET (zobacz instrukcję dla Linux),

- Biblioteki .NET Framework w wersji 4.0,

- Pamięć RAM: 64MB,

- Aktywne połączenie z Internetem.

Google Index Checker w wersji 1.0 udostępniam na licencji Freeware.

Fajny programik, rzeczywiście skuteczność 100% w szybko przeprowadzonym teście. Szkoda tylko, że przy każdym uruchomieniu trzeba wpisywać hasło – mało to wygodne. No i fajnie by było gdyby można było maksymalizować okno programu, ale to nie jest aż tak istotne. Super programik, dzięki!

W kolejnych programach/wersjach będę kombinował z mechanizmem cachowania danych autoryzacyjnych, co z tego wyjdzie zobaczymy. Maksymalizację okna raczej sobie darujemy bo wtedy program wygląda śmiesznie na monitorze 22 calowym, lepiej wygląda już taki mały żuczek 😉

Taką funkcjonalność posiada także Scrapebox, ale jeżeli ktoś nie posiada to Twój program może być bardzo pomocny. Przydatna byłaby możliwość dodania proxy, aby szybko nie zablokować sobie Google. Fajnie, że udostępniasz taki soft.

W celu minimalizowania ryzyka zostało wprowadzone losowe opóźnienie. Proxy już jest testowane w nowszej wersji, tyle że przy udziale proxy skuteczność programu spada.

szybkie pytanie do Autora:

program niestety bardzo szybko mi się zwiesza. Czy jest jakaś maksymalna ilość linków, którą program jest w stanie sprawdzić jednorazowo? Czy nie jest to czasem związane z ilością zapytań z jednego IP? Jeśli tak, to czy jest jakaś możliwość podpięcia pod program proxy?

Program testowałem na kilku paczkach po 200 linków, zarówno z włączoną opcją „Symuluj człowieka” jak i bez niej wszystko było ok. Obecna wersja wprawdzie nie obsługuje proxy, lecz zawsze można cały ruch przekierować używając do tego celu zewnętrzne narzędzia typu ProxyCap.

rozumiem. niestety nie miałem na myśli paczki o wielkości 200 linków 😉 ze sprawdzeniem indeksacji takiej ilości zwykle nie mam problemu. problemy zaczynają się w ilościach kilku, kilkunastu, a nawet kilkudziesięciu tysięcy linków. Niestety chyba dobrze rozumiem, że TO narzędzie nie jest przeznaczone dla takich ilości…?

Przy 200 adresach mogłem sprawdzić skuteczność programu ręcznie… no może nie do końca ręcznie bo przy użyciu iMacros ale przy manualnym wglądzie czy jest ok. A przy większej ilości kilku tysięcy nie testowałem, ponieważ zabrałoby to za dużo czasu. W przypadku tak dużych ilości obawiam się, że losowy czas opóźnienia to za mało 😉

Zalajkowałem stronę na Facebooku, ale w sekcji Free SEO Tools widzę tylko ciąg kodu i nic więcej. Może jakiś błąd wyskoczył i to powoduje, że ani nie widać kodu, ani nie ma skąd pobrać programu.

Dzięki za info. Sprawdziłem teraz i wszystko działa jak należy – na Google Chrome. Sugeruję wyczyścić ciasteczka i spróbować ponownie. Jeśli nie będziesz mógł dostać się do podstrony, proszę napisać na mail, mile widziany zrzut ekranu z FB 😉 Pozdrawiam!

Artur… link był podany w treści artykułu 😛 https://techformator.pl/files/programy-seo/googleindexchecker.rar

Paweł, Arturowi chodziło o brak hasła na fanpage’u. U mnie też wyświetlał się sam kod i po wyczyszczeniu ciastek jest to samo pod FF. Pod Chrome jest OK… zaraz potestuję 🙂

Pobrałem. Program faktycznie wskazuje dobre pozycje i inne parametry, jednak za każdym razem się zawiesza i muszę go zrestartować.

Program ma „wyciszone” wszelkie błędy. Komunikaty użytkownikom nie będą pokazywane, ta kwestia będzie uzupełniona w kolejnych wersjach. Natomiast zawsze można zobaczyć co siedzi w dziennikach zdarzeń. Prześlij mi na mail dzienniki EVT lub EVTX w zależności jaki system Masz. Instrukcję znajdziesz na hotfix >> http://www.hotfix.pl/podglad-zdarzen-zapisywanie-dziennikow-xp-vista-windows-7-a47.htm

Super aplikacja i ułatwia rzeczywiście te czynności:) Masz głowę na karku 🙂 Dzięki i pozdrawiam serdecznie

Już ruszyło pod przeglądarką Firefox, niestety nie używam Chrome, bo to zło wcielone, więc nie miałem jak sprawdzić jaki jest kod dostępowy do programu.

witam, czy jest możliwość napisania przez autorów jakiegoś API do serwera (oczywiście nawet w wersji płatnej) aby aplikacje web’owe mogły odpytywać się o zaindeksowane adresy?? czy planujecie jakieś API ?

Żeby zrobić API musiałbym przepisać aplikację na język PHP i umieścić ją na serwerze. Google Index Checker jest programem okienkowym dla Windows, na Linux też go uruchomimy albo via Wine lub poprzez środowisko Mono.

czekamy więc z utęsknieniem na taką możliwość (web api), przydałby się bardzo rożnym narzędziom, nie tylko tym popularnym dla wszystkich (komercyjnym także), ale wewnętrznym, z których korzystają różne firmy seo, uważam że można by także zapłacić za taką subskrypcję api (w zdroworozsądkowych cenach) 🙂

Dzięki za propozycje, na pewno takie rozwiązanie jest do rozważenia 😉

Dzięki za kolejne fajne narzędzie 🙂

Podoba mi się, że działa na Win7. U mnie na x64 śmiga aż miło, pozostaje zabrać się do roboty i zestawić wszystkie linki z katalogów, precli…

Bardzo fajny programik , u mnie smiga aż milo. Byle wiecej takich pomyslów. Pozdrawiam i czekam na kolejne:D

bardzo fajne narzedzie, dzieki

ale niestety, nie działa do tzw. głębokich linków, tj np sprawdzanie wpisow w niektorych katalogach itp ktore sa w formie z parametrami 🙁

A aktualnie testuje pewne rozwiazanie i mam do sprawdzenia 600url’i wiec bardzo bym potrzebowal czegos automatycznego co sprawdza albo dokladny adres strony z parametrami lub ew. czy wpis siedzi w cache

Adresy z parametrami także są obsługiwane, lecz na wyjściu możemy dostać więcej danych podlegających analizie stąd wydłużenie czasu rozpoznawania. Jak dotąd nie zauważyłem, aby program nieprawidłowo klasyfikował tego typu linki, co nie oznacza, iż taki scenariusz nie może się przydarzyć – jest to możliwe właśnie z uwagi na brak ograniczenia ilości danych biorących udział w analizie. Aby potwierdzić błąd musiałbym mieć przynajmniej kilka adresów URL, które zostały błędnie sklasyfikowane przez program.

Wiele programów klasyfikuje adresy poprzez dopasowanie ścisłe w wyszukiwaniu, lecz takie założenie na starcie jest błędne i nieoptymalne… więc tak jak mówisz, aby precyzyjnie rozpoznawać tego typu adresy należy wykorzystać Google Cache. Najnowsza nieoficjalna wersja programu (1.01) dostępna dla betatesterów tej funkcji nie posiada, do uzupełnienia 😉

Dzięki za informacje!

@ „Wiele programów klasyfikuje adresy poprzez dopasowanie ścisłe w wyszukiwaniu, lecz takie założenie na starcie jest błędne i nieoptymalne…”

właściwie to dlaczego?

poza tym jesli program nie stosuje scislych dopasowan to w jaki sposob dziala (tak pokrótce, jesli to nie tajemnica) i jak rozróżnia adresy, jeśli np są na jakimś forum gdzie są one w formie:

hxztp://www.forum/viewtopic.php?f=3&t=111

i w takim przypadku zauwazylem ze komenda site zwraca liste wynikow

hxztp://www.forum/viewtopic.php?f=3&t

np.

hxztp://www.forum/viewtopic.php?f=3&t=112

hxztp://www.forum/viewtopic.php?f=3&t=311

itd….

a wpisu

„http://www.forum/viewtopic.php?f=3&t=111:”

nie ma w indexie…

Załóżmy że dodaliśmy stronę do katalogu, następnie podlinkowaliśmy ją jedną z dostępnych metod, powiedzmy wykorzystaliśmy do tego fora (tematy/profile). Stosując dopasowanie ścisłe szukamy czy dany wpis jest zaindeksowany czy nie, na wyjściu niejednokrotnie zobaczymy dużą ilość danych, które nijak mają się do wyniku indeksacji. W wynikach wyszukiwania mogą być zaindeksowane tematy z forum zawierające linki do naszego kochanego wpisu w katalogu – frazy którą szukamy. Do czego zmierzam, wpisy na forach mogą zostać szybciej zaindeksowane, przez co po wykonaniu zapytania w dopasowaniu ścisłym na wyjściu dostaniemy błędne wyniki i dany adres zostanie źle sklasyfikowany. Oczywiście ktoś może powiedzieć, iż można to wszystko odpowiednio przefiltrować i sklasyfikować, owszem można tylko po co? To jest tylko utrudnianie sobie życia, a taka aplikacja jest totalnie nieoptymalna.

Powszechnie wiadomo, iż operator site służy właśnie do określania zaindeksowanych stron. Jeśli zastosujemy go w odniesieniu do konkretnego adresu zawsze zwróci wartość 0 lub 1. Jeśli wpis został przetworzony i umieszczony w indeksie ZAWSZE zostanie wylistowany. Nie ma to najmniejszego znaczenia, że operator jest niedokładny, niedokładność objawia się wyłącznie w sytuacjach gdy sprawdzamy całe domeny np. site:www.domena.pl

Kiedyś na PiO jaśnie oświecony Kojotek wielce się rzucał jakoby metoda była zła – bzdura, jeszcze bredził o supplemental index twierdząc że jak wpis jest w SI to nie działa. Wpisy aby znalazły się w SI MUSZĄ zostać przetworzone przez wyszukiwarkę, na logikę muszą być również umieszczone w bazie (indeksie) wyszukiwarki – inaczej indeks uzupełniający nie miałby racji bytu. Stosując operator site ograniczamy ilość wyników do domeny, a w odniesieniu do konkretnego adresu URL wynik zostaje ZAWSZE ograniczany do ów adresu, i na wyjściu albo coś mamy albo nie.

Dlatego śmiem twierdzić a nawet wiem to na 100%, że Kojotek, który pozjadał wszystkie rozumy na PiO popełnił jedną z największych swoich wpadek w historii i najwyraźniej nie ma zielonego pojęcia o czym pisze.

Dlaczego nieoptymalne? Nieoptymalne z uwagi na dużą ilość danych które podlegają filtrowaniu. Tam gdzie jest to możliwe (a przy sprawdzaniu indeksacji jest) należy minimalizować ilość danych, które poddajemy obróbce.

Co do przykładów…

Żebym mógł się odnieść do tego potrzebuję konkretów, podałeś wxw.forum, takie coś zawsze na wyjściu będzie zwracało błąd 😉 Zaindeksowany adres z parametrem da wynik pozytywny, lecz na wyjściu będziemy mieli często więcej niż jeden wynik, przez co wydłuży się jedynie czas klasyfikacji. Choć tak jak mówię, jeśli masz adresy które są błędnie klasyfikowane proszę podeślij mi je na mail, sprawdzę sytuację.

PS. Sytuacja którą opisuję dotyczy linków o przyjaznej strukturze, nie dot. form z parametrami. Tutaj są inne reguły.

Witaj!

Dzięki za przydatne narzędzie.

Mam pytanie – czy planowane jest poszerzenie programu o inne wyszukiwarki? Przede wszystkim Bing i Yahoo. Ja wiem, że Google to potęga, ale na potrzeby rynku angielskiego trzeba wziąć pod uwagę także tamte 2 wyszukiwarki.

Wojtek, dzięki za propozycję. Nie myślałem o tym. Na ten moment program jest bardzo młody, wszystko przed nim 😉

Jak dotąd zero problemów. Chyba zrobiłeś jeden z najlepszych darmowych programów tego typu na polskim rynku.

PS. Zgodzę się z przedmówcą, warto zrobić wyszukiwanie nie tylko dla google pl ale także dla innych wyszukiwarek np. Bing.

Pozdrawiam Tomek

Świetny programik – i do tego za darmo! I pomyśleć, że przez ostatnie miesiące sprawdzałem site ręcznie. Teraz mam dużo więcej czasu na inne rzeczy. Wielkie dzięki za udostępnienie 🙂

Ja do tej pory korzystałem ze scrapebox’a, ale ostatnio w ogóle przestała ta funkcja działać. Wszystko co wrzucam pokazuje jako niezaindeksowane.

Twój soft spadł mi z nieba 🙂 wielkie dzięki teraz będę korzystał z niego na co dzień.

Nie żebym jakoś specjalnie reklamował, ale dla mnie najtańszym rozwiązaniem jeśli chodzi o proxy jest proxy market. Za 9zł mam 10 adresów ip na 30 dni. Adresy są publiczne, ale co jakiś czas odświeżane więc cały czas działające. W scrapebox sprawdzam sobie czy działają i można na nich leciec.

Coś pachnie reklamą… 😉

A na poważnie, proxy market ma jedną podstawową wadę – korzysta z publicznych proxy. Wolałbym dołożyć parę groszy i mieć dostęp do prywatnego proxy, gdzie miałbym pewność, że stabilność połączenia zawsze będzie reprezentowała przyzwoity poziom.

Mariusz nigdy wcześniej nie korzystałem z Twojego softu chętnie bym to zrobił, ale mimo lajkowania nie mogę znaleźć linku do jego pobrania. Gdzie go znajdę?

Link jest zawarty w głównym poście o GIC tj. https://techformator.pl/sprawdzanie-indeksacji-google-index-checker/

nie dziala mi haslo podane na fanpage te co konczy sie ) pomzecie chcialbym przetestowac programik

Napisz w tej sprawie do mnie na priv. Być może dostałeś 403 forbidden i nie przechodzisz autoryzacji.

Witaj,

nod32 antyvirus 5 zwraca monit o potencjalnie niepożądanej aplikacji – MSIL.Packed.CodeFort.A w Twoim archiwum.

Mógłbyś to proszę zweryfikować ?

Witaj!

Plik nie zawiera żadnego złośliwego kodu. Kilka tygodni temu był skrupulatnie badany pod tym kątem, tylko ESET wykrywa, lecz nie jest to wirus tylko MSIL/CodeFort – dołączona instrukcja do blindingu kodu.

W związku z powyższym należy wnioskować, iż ESET wypuszcza błędny komunikat false positive.

Dziękuję za zgłoszenie.

Ten program to coś wspaniałego. Jak wiadomo odwiecznym problemem dla ludzi zarówno zajmujących się profesjonalnie, jak i amatorsko SEO była indeksacja wpisów na stronach zapleczowych, w katalogach, preclach itd. Próbowałem rozwiązać ten problem przy użyciu serwisów pingujących, ale kiedy miałem już do pingowania ponad 300 stron z linkami to był naprawdę duży problem dla mnie, potrzebowałem właśnie takiego programu jak Pingomat, który zrobiłby to wszystko dla mnie.

Jak program sprawdza indeksację? Zauważyłem że z „nieprzyjaznymi” linkami ma problemy. Site dla adresu typu adres.pl/?id=1234 często jest spore a adres ten może być niezaindeksowany. Z kolei znalazłem adres podobny (nie przyjazny) i komenda info: zwraca mi 1 wynik, a program wrzuca do niezaindeksowanych.. Czy ja gdzieś źle rozumuję czy program nie jest dopracowany dla urli starej generacji?

W razie czego proszę o info o odp. na maila, bo mogę zapomnieć że zadałem takie pytanie tu 😉

Witaj.

Wersja z parametrami jest sprawdzana poprzez Google Cache, jeśli strona zwraca 404 to jest klasyfikowana jako niezaindeksowana więc może tutaj zdarzyć się tak, iż strona będzie zaindeksowana, a nie będzie jej w Cache. Zrzuty witryn w cache pojawiają się czasem ze sporym opóźnieniem. Metoda sprawdzania adresów z parametrami wymaga ulepszenia bez dwóch zdań 🙂

Pracuje nad rozszerzeniem wyszukiwania, dla Gcache będą nowe metody sprawdzania, dla adresów przyjaznych także. Nowych funkcji będzie można się spodziewać w wersji 1.3 lub 1.4.

Dziękuję za szybką odpowiedź i mam nadzieję, że poprawione i bogatsze wersje będą również za darmo udostępnione do pobrania na Twoim blogu… Pozdrawiam.

Program bardzo fajny ale się zawiesza przy większych plikach. Kiedy możemy się spodziewać nowej wersji?

Nie prędko, albowiem na tym etapie zdecydowałem się na całkowitą przebudowę aplikacji. Najbliższe wydanie to 2.0, wersja 1.2 będzie prawdopodobnie uzyskiwała tylko krytyczne aktualizacje o ile będą konieczne.

Ok. Źle wyświetla się w 1600×900. Chexbox „Symuluj człowieka kryje się pod „Auto zapis TXT”. Tak samo logo Techformator.

Czy autor planuje usuniecie wpisywania za każdym razem hasła? 🙂 Przydałoby się..Wystarczy 8 razy a każdy zapamięta;)

Dzięki.

Ciężko będzie to teraz sprawdzić i wprowadzić modyfikację ale będę pamiętał o tym. Jak tylko będzie sposobność do testów wykonam je i zobaczę co w trawie piszczy.

Mechanizm cachowania autoryzacji musi być wdrożony. Na ten moment nic więcej nie mogę powiedzieć.

Świetny programik 🙂 dzięki. Nie testowałem co prawda na większych ilościach linków ale na małych ilościach program zachowuje się dobrze.

Dzięki bardzo, program bardzo się przydał. Ręczne sprawdzanie linków z katalogowania i presell to była katorga 🙁

Witaj Mariusz,

czy planujesz w najbliższym czasie wydać nowa wersję Google Index Checker?

Pytam, ponieważ fajny jest ten Twój program ale brakuje mi w nim obsługi Proxy bo przy większej ilości linków Google blokuje dostęp do wyszukiwarki.

W najbliższych 2 miesiącach nie ma na to raczej szans.