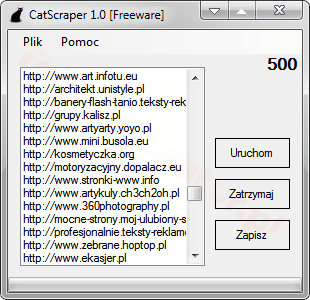

Oprócz pozycjonowania stron zajmuję się także tworzeniem SEO botów. Wszystkie mają na celu zautomatyzować powtarzające się czynności lub usprawnić proces pozyskiwania danych (Data Mining). W niniejszym wpisie chciałbym przedstawić jeden z autorskich programów SEO. Program nosi nazwę CatScraper i jego zadaniem jest tworzenie listy katalogów na podstawie zebranych danych. Aplikacja jest bardzo prosta, ale pozwala zaoszczędzić sporo czasu.

W jednym z poprzednich artykułów opisałem, jak można pozyskać adresy katalogów wykorzystując darmowy dodatek do przeglądarki Google Chrome – XPath Scraper. Niestety zaprezentowana metoda jest dobra w odniesieniu do niewielkich zbiorów danych, dlatego też z biegiem czasu stworzyłem kilka programów, które automatyzowały proces pozyskiwania katalogów. Jednym z nich jest CatScraper.

Wersja 1.0 pobiera informacje tylko z jednej witryny. Na tę chwilę można wyłuskać 3449 katalogów. Natomiast docelowo mam zamiar rozszerzyć funkcjonalność do ponad 30 stron polskich i zagranicznych, szacunkowo będzie można pozyskać nawet 60-tysięcy adresów. Nie zdecydowałem jeszcze, czy rozszerzona wersja będzie darmowa.

UWAGA! Przed użyciem programu zapoznaj się z plikiem przeczytaj-TO.txt

CatScraper dostarczany jest w formie bezinstalacyjnej. Aplikację uruchamiamy poprzez plik CatScraper.exe – po włączeniu programu klikamy Uruchom i od tego momentu rozpoczyna się proces zbierania informacji. Proces można w każdej chwili zatrzymać. Listę można wyeksportować do pliku TXT (przycisk Zapisz).

Wymagania:

- System operacyjny XP, Vista, Windows 7 32/64-bit lub Linux ze środowiskiem Wine i wgranymi bibliotekami Microsoft .NET (zobacz instrukcję dla Linux),

- Biblioteki .NET Framework w wersji 4.0,

- Pamięć RAM: 64MB,

- Aktywne połączenie z Internetem.

CatScraper w wersji 1.0 udostępniam na licencji Freeware.

Aktualizacja: 5.02.2013 r.

Program można pobrać z fanpage, zakładka Free SEO Tools.

Aktualizacja: od dłuższego czasu aplikacja nie była rozwijana, w związku z czym, z dniem 16.06.2019 wsparcie dla programu zostaje wstrzymane. Program będzie niedostępny do pobrania. Być może w przyszłości na bazie programu stworzę nowy, o większych możliwościach.